Τελικά, το ρομπότ είναι τέρας;

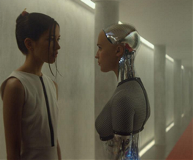

Συνήθως αντιμετωπίζουμε την επιστημονική φαντασία ως μυθοπλασία με «άρωμα» επιστήμης ― και δικαίως, αφού η επίγεια καθημερινότητα είναι αρκετά περίπλοκη ακόμα και χωρίς τον φόβο εχθρικών εξωγήινων ή εξεγερμένων ρομπότ. Βέβαια, κάποια «τραβηγμένα» σενάρια ίσως κρύβουν δόσεις αλήθειας. Oταν ο Στίβεν Χόκινγκ μιλάει για το τέλος του ανθρώπινου είδους, ο Ελον Μασκ προειδοποιεί ότι ξυπνάμε έναν «δαίμονα» και ο Μπιλ Γκέιτς παραδέχεται ότι τρέφει ανησυχίες, όταν εκατοντάδες επιστήμονες και ηγετικά στελέχη εταιρειών ψηφιακής τεχνολογίας συνυπογράφουν ανοιχτή επιστολή για τους κινδύνους της τεχνητής νοημοσύνης, όταν ομάδα «γραφικών» διαδηλωτών (που στις 15 Μαρτίου φώναξε «Σταματήστε τα ρομπότ!» έξω από το φεστιβάλ South by Southwest του Τέξας) αποδεικνύεται ότι απαρτίζεται από μηχανικούς υπολογιστών και φοιτητές σχολών Πληροφορικής, τότε ο μέσος άνθρωπος έχει κάθε λόγο να αντιμετωπίζει με καχυποψία τις «έξυπνες» συσκευές του.

Στα πιο απτά δείγματα της προόδου που έχει σημειωθεί τις τελευταίες δεκαετίες στον χώρο της τεχνητής νοημοσύνης συγκαταλέγονται τα μη επανδρωμένα αεροσκάφη, τα αυτοοδηγούμενα οχήματα –σε δοκιμαστικό στάδιο–, τα βιονικά τεχνητά μέλη, οι διαδικτυακές μηχανές αναζήτησης, οι «ψηφιακοί βοηθοί», όπως ο Siri, και οι εφαρμογές που αποδίδουν καλύτερα από τον άνθρωπο σε πεδία όπως το σκάκι. Στο ετήσιο πρωτάθλημα ποδοσφαίρου Robocup, οι αθλητές είναι αποκλειστικά ρομπότ που αναπτύσσουν πολύτιμες ικανότητες, π.χ. συνεργασία, αναγνώριση, προσαρμογή κ.ά.

Μυστικότητα

Ολα αυτά είναι μόνο η κορυφή του παγόβουνου, αφού οι πιο φιλόδοξες έρευνες πραγματοποιούνται υπό καθεστώς μυστικότητας στα εργοστάσια όπου κατασκευάζονται οπλικά συστήματα –τον Μάιο του 2014, το ζήτημα των αυτόνομων ρομπότ με δυνατότητα άσκησης θανάσιμης βίας συζητήθηκε σε ανεπίσημη συνάντηση ειδικών του ΟΗΕ– ή στα εργαστήρια της Google, η οποία έχει βάλει στόχο να εξαγοράσει τις σημαντικότερες εταιρείες τεχνητής νοημοσύνης ανά τον κόσμο. «Συζητήσεις για το ηθικό θέμα πάντα υπάρχουν, όχι τόσο με βάση την τεχνολογία που διαθέτουμε τώρα όσο με βάση την κατεύθυνση προς την οποία θέλουμε να πάμε», υπογραμμίζει ο Κώστας Καρπούζης, κύριος ερευνητής στο Ινστιτούτο Συστημάτων Επικοινωνιών και Υπολογιστών της Σχολής Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών του ΕΜΠ, με «ειδίκευση» στην επικοινωνία ανθρώπου - μηχανής και την αναγνώριση συναισθημάτων από υπολογιστές. «Αυτή τη στιγμή η τεχνολογία περιορίζεται σε συγκεκριμένα πεδία: ένα αεροπλάνο που μπορεί να πετάει μόνο του μετά την απογείωση και πριν από την προσγείωση ή ένας συρμός του μετρό. Από εκεί και πέρα το ζήτημα είναι κατά πόσο εκχωρούμε τη δυνατότητα στις μηχανές να αποφασίζουν μόνες τους τι θα γίνει αν, για παράδειγμα, το αεροπλάνο δει ότι μπροστά υπάρχουν αναταράξεις. Θα στρίψει μόνο του ή θα πρέπει ο πιλότος να αλλάξει την πορεία χειροκίνητα;».Κάθε βήμα προόδου εγείρει νέα ηθικά διλήμματα: Αν ένα ρομπότ έχει την ικανότητα να λαμβάνει αποφάσεις, πώς εγγυόμαστε ότι θα κάνει τη σωστή επιλογή; Αν αυτή η επιλογή έχει ηθικές προεκτάσεις –για παράδειγμα, η καταστροφή ενός στόχου όπου πιθανότατα βρίσκεται ένας επικίνδυνος εχθρός, αλλά και αρκετοί άμαχοι– ποιος πρέπει να θεωρηθεί υπεύθυνος για τις συνέπειές της, ο κατασκευαστής, ο ιδιοκτήτης ή το ίδιο το ρομπότ; Και πώς εξασφαλίζουμε ότι ένα καθ’ όλα «υπάκουο» ρομπότ δεν θα «χειραγωγηθεί» από ομάδα κακόβουλων χάκερ;

Τεχνικά, η δυνατότητα να δώσουμε στις μηχανές την ικανότητα να λαμβάνουν αποφάσεις υπάρχει ήδη, διευκρινίζει ο κ. Καρπούζης. «Εμείς απλώς επιλέγουμε αν θα την εκχωρήσουμε, ας πούμε στον υπολογιστή του αεροπλάνου. Αλλά το να αποφασίζει ένα ιατρικό μηχάνημα αν ένας ασθενής δεν έχει ελπίδα και να τον αποσυνδέει... αυτό είναι σενάριο επιστημονικής φαντασίας». Το ίδιο ισχύει για το ενδεχόμενο οι μηχανές μας να αποκτήσουν συνείδηση, αντίληψη του εαυτού τους και την ικανότητα για συναισθήματα. «Δεν υπάρχει πιθανότητα να φτάσουμε ως εκεί, με δεδομένους τους περιορισμούς που έχουν οι μηχανές οι ίδιες», τονίζει ο ερευνητής, χωρίς αυτό να σημαίνει ότι δεν μπορεί κάποια στιγμή να γίνει το λάθος «να εκχωρηθεί μεγάλη δύναμη σε ένα λογιστικό σύστημα»...

Αστάθμητος παράγοντας

Η πραγματική απειλή δεν έγκειται στην ευφυΐα των υπολογιστών, αλλά στον αστάθμητο ανθρώπινο παράγοντα. «Το ζήτημα είναι τι δικαιώματα θα δώσουμε εμείς στις μηχανές», αναφέρει ο ερευνητής. «Υπάρχουν μηχανές που παίζουν στο χρηματιστήριο μόνες τους. Τους δώσαμε όμως το δικαίωμα, γνωρίζοντας το ρίσκο. Αλλά στον τομέα της υγείας, είναι πολύ περιορισμένο το περιθώριο που αφήνουμε».

Πάντως προσωπικότητες σαν τον Χόκινγκ ή τον Γκέιτς υπογραμμίζουν τη σημασία δημιουργίας νομικού πλαισίου και της ανάπτυξης μεθόδων για τη διασφάλιση της σωστής λειτουργίας των «σκεπτόμενων» μηχανών, χωρίς να ζητούν να διακοπούν οι έρευνες στην τεχνητή νοημοσύνη. Ένα άλλο πρόβλημα είναι η απώλεια της ιδιωτικότητας. «Νομίζω ότι πρέπει να αρχίσουμε να συνηθίζουμε στην ιδέα ότι δεν θα είμαστε ασφαλείς, ούτε θα έχουμε ιδιωτικότητα», υποστηρίζει ο κ. Καρπούζης. «Οι προδιαγραφές ασφαλείας», που έχουν συσκευές όπως τα «έξυπνα» ρολόγια, τα ψυγεία ή οι αυτοματοποιημένοι συναγερμοί, «είναι ελάχιστες μπροστά στους κινδύνους που υπάρχουν». Εντούτοις, όλα αυτά σχετίζονται περισσότερο με το «πώς υλοποιούνται τα πρωτόκολλα ασφαλείας και ελάχιστα με θέματα τεχνητής νοημοσύνης».

Πηγή: Εφημερίδα Καθημερινή 29/03/2015, Χριστίνα Σανούδου (αρθρογράφος)